保险公司采用人工智能:了解使用的道德伦理

法再发布的 “人工智能与保险的未来 ” 探讨了在保险业务中采用人工智能 (AI) 时需要考虑的几个关键点。在本文中,我们将审视法再对保险公司在人工智能时代必须牢记的道德伦理方面的见解。

任何新技术的采用都会带来最初的恐惧或担忧。在将人工智能模型应用于业务时,人们的担忧尤其指向人工智能和道德伦理问题。一些人担心人工智能可能会带来偏见、歧视和不公平的保险实践和操作。

针对这些担忧,保险公司在制定人工智能部署策略时必须重新评估其定价和风险选择实践操作,以实现更公平的保险。 但我们该怎么做呢? 目前还没人知道答案。

在监管严格的保险行业中,保险风险选择和定价的公平性并不是一个新话题,但最近人工智能的出现带来了额外的压力。 保险是一个数据驱动的行业; 因此,监控模型的准确性和公平性的流程已经就位。

然而,现有技术需要加强,因为强大的人工智能模型能够从输入数据中学习辨别模式,即使受保护的字段不出现。 例如,在汽车保险中,人工智能模型可以通过查看保单持有人的汽车特征来猜测或代理申请人的性别。

最近人工智能的热潮引发了人们对算法使用的数据可能会产生偏见的认识。 我们需要提醒自己,人工智能模型并不是有意歧视任何人或任何事物。 这只是对它们经过训练的数据的反映。

例如,想象一下打造一家公司的形象:如果公司的大多数员工都是白人男性,那么经过训练的模型生成该公司员工的典型概貌时,将会显示一张白人男性的图片,除非给予特定的去偏见指令。 几十年来,精算师和数据科学家一直在通过从数据集中删除敏感变量来解决公平性问题,这可能会导致不公平的价格。

然而,随着当前人工智能能力的迅速扩展,迫切需要找到一种新的技术来构建更公平的定价模型。为了了解性别、种族、出身或婚姻状况等敏感变量对保险建模中的公平性产生多大的影响,包括法再的数据科学家在内的一组研究人员进行了模型模拟研究。

这项研究发现,仅仅移除敏感变量并不一定会产生更公平的模型,因为它们通常与其他风险因素相关。为了试验可能的解决方案,该团队开发了一种新的算法来减轻风险建模中的代理歧视。

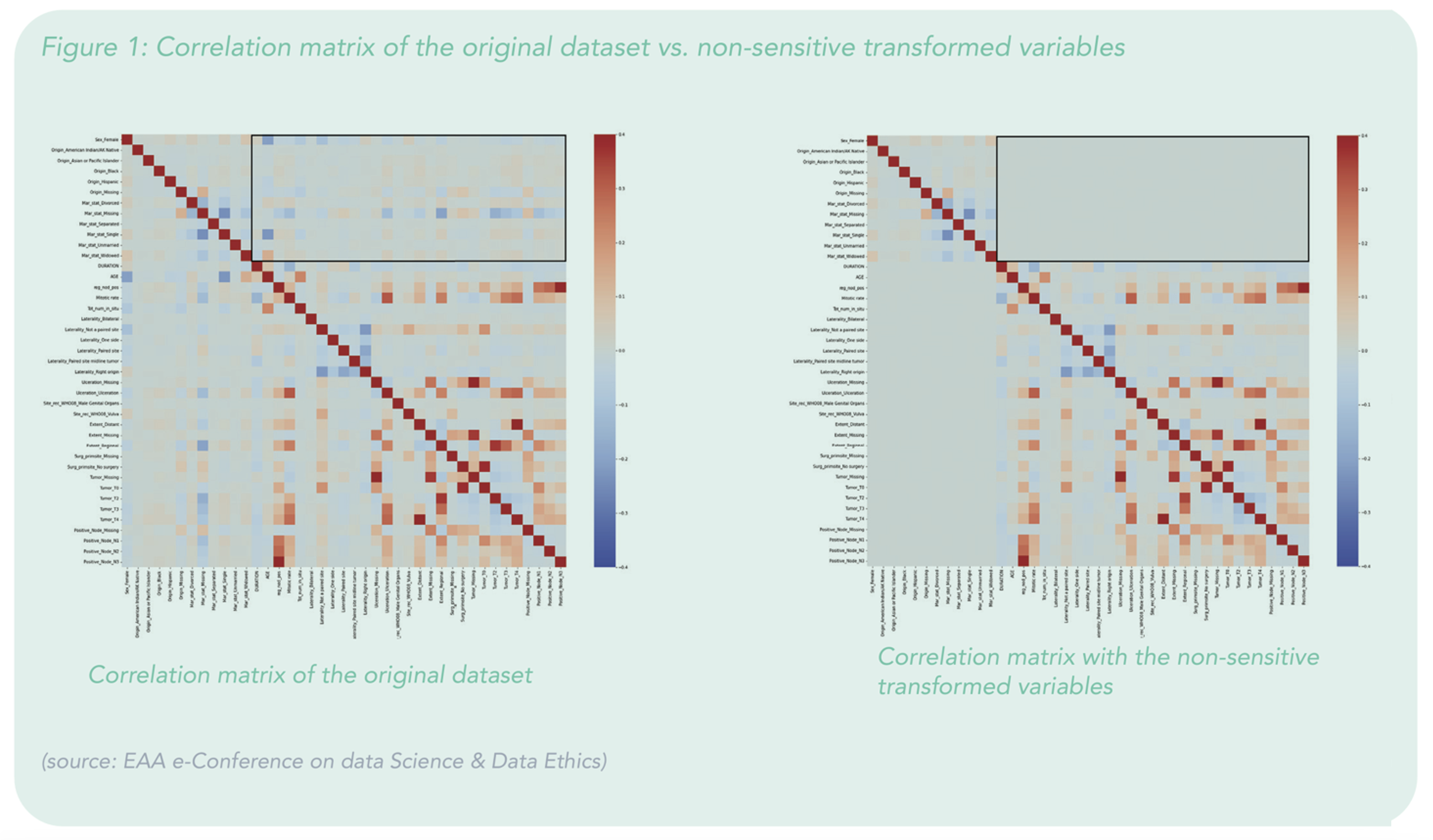

图 1 展示了对皮肤非转移性黑色素瘤患者进行更公平风险选择的真实案例应用。 如两个相似图表的方框区域所示,变量转换成功消除了非敏感和敏感变量之间的相关性。 使用线性模型的第一个解决方案开发为建模前数据准备设定了一些首要原则。

未来几年,人工智能的更广泛应用将不可避免地使保险行业暴露出数据偏见。我们需要更加警惕,以避免代理歧视,并在我们的决策过程中保持公平。在保险定价和风险选择的公平性方面,很难找到一个全球统一的定义,因为各国的公平性存在很大差异,不容易定义或达成一致意见。该定义受到市场特定因素的影响,例如监管、社会结构、消费者情绪、科学进步、技术能力等。

我们可以使用不同的公平性衡量标准来测试人工智能模型,但它们仍然可能导致矛盾的结论。 即使我们清楚地了解公平性对于特定人工智能模型意味着什么,如果数据不足(例如,在模型校准期间无法访问受保护的变量)或包含偏见,那么衡量公平性仍然存在挑战。 最终,由每个市场的权威机构来确定最合适的定义,从而确定最合适和最符合道德伦理的建模。

欢迎深入了解法再发布的 “人工智能与保险的未来”中有关人工智能的机遇、挑战、采用和伦理的内容。欲了解更多关于我们的数字解决方案如何帮助您为保单持有人提供支持并使您的业务得到增长,请点击此处。